Das menschliche Auge.

Bei der Vorbereitung zu meinem letzten Kurs „Besser fotografieren“ habe ich mich auch mit unserem Sehorgan, dem Auge ein wenig mehr besch√§ftigt und will deshalb hierzu einige Fakten nennen, die mir selbst bisher nicht bekannt waren und die mir aber dann doch ein bisschen mehr die Augen ge√∂ffnet haben.

Zäpfchen und Stäbchen.

Die Lichtimpulse werden in der Retina von Z√§pfchen und St√§bchen eingefangen. Die Zapfen haben farbempfindliche Eiwei√üstoffe eingelagert und sorgen so daf√ľr, dass wir Farben unterscheiden k√∂nnen. St√§bchen hingegen sind nur empfindlich auf Helligkeitswerte, aber mit einer extrem hohen Empfindlichkeit, die bei v√∂lliger Dunkelheit sogar einzelne Lichtquanten erfassen k√∂nnen.

Wissenschaftlich wird bei den Z√§pfchen nicht von Farbempfindlichkeit gesprochen, sondern von der Empfindlichkeit f√ľr Wellenl√§ngen. Prim√§r haben wir drei Zapfentypen; das eine ist f√ľr rot empfindlich, das andere f√ľr gr√ľn und das dritte f√ľr blau. Rot ist langwellig und hat eine Absorption von 564 Nanometer, gr√ľn ist in der Mitte bei 530 Nanometer und blau sowie UV ist das kurzwellige Licht und das liegt bei 420 Nanometer. Auch die Verteilung der Z√§pfchen ist unterschiedlich: 60 % sind f√ľr rot, 30 % sind f√ľr gr√ľn und 10 % sind f√ľr blau empfindlich.

- Die wissenschaftlichen Hintergr√ľnde kann man hier nachlesen (englisch): The Organization of the Retina and Visual System.

- Sehr gut schulisch aufbereitet ist das Thema auf dieser Webseite von Bayern 2 Radio: Die Welt in Color.

- Das Sendemanuskript gibt es hier zum download: Das Sendemanuskript.

Anzahl der Zäpfchen und Stäbchen.

Das menschliche Auge hat ca. 6 Millionen Z√§pfchen, aber mehr als ca. 120 Millionen St√§bchen (Faktor 20). Das hei√üt, dass wir Menschen prim√§r f√ľr die Unterscheidung von Helligkeitswerten optimiert sind. Und es ist ja in der Tat so, dass wir Nachts zwar keine Farben sehen k√∂nnen (weil das Licht fehlt, um Reflexionen zu erzeugen), aber wir uns trotzdem sehr gut anhand der Grauwerte in unserem Umfeld orientieren k√∂nnen.

Die Welt ist nicht bunt.

Es geht aber noch einen Schritt weiter mit dem Thema Farbe sehen. Was wir als Farbe wahrnehmen, gibt es physikalisch √ľberhaupt nicht, sondern wird von unserem genialen Gehirn erzeugt; ein Mechanismus, der bis heute nicht vollst√§ndig verstanden ist. Eine physikalische Eigenschaft „rot“, „gr√ľn“ und „blau“ gibt es nicht. Farben zu unterscheiden hat unser Gehirn erst in Laufe der Evolution entwickelt. Das ist bei Mensch und Tier durchaus sehr unterschiedlich ausgepr√§gt, wie die medizinische Forschung inzwischen wei√ü. Dass rote (reife) Fr√ľchte eher genie√übar sind haben Mensch und Affe im Laufe der Evolution gelernt. Diese (Farb-)Wellenl√§ngen-Information wird √ľber die Z√§pfchen ans Gehirn geleitet und erst dort als Farbe dargestellt. In Wirklichkeit ist die Welt also v√∂llig farblos. Es gibt nur unterschiedliche Helligkeiten. Man muss sich damit erst einmal gedanklich auseinandersetzen und sich eine Welt nur mit Graut√∂nen unterschiedlicher Helligkeiten vorstellen. Schlie√ülich ist unsere farbige Umwelt ja etwas, was wir von Kindesbeinen an gewohnt sind. Sozusagen eine Urerfahrung.

Auch unsere digitalen Sensoren k√∂nnen nur Helligkeiten unterscheiden. Erst durch die √úberlagerung mit einem Color Filter Array (CFA) werden die Farbinformationen hinzugef√ľgt. Wie in unserem Gehirn.

Bei der Leica Monochrome wird dieses CFA weggelassen und wir bekommen damit ein reales Abbild unserer Welt bestehend nur aus Helligkeiten. Das allein w√§re f√ľr mich inzwischen ein Grund, mir diese Kamera zu kaufen, um unsere Welt so sehen zu k√∂nnen wie sie tats√§chlich ist. Allerdings ist mir der Betrag zum Erwerb des Ger√§tes dann doch zu hoch, um hier spontan einen Kauf zu t√§tigen. Wie man aus einem digitalen Farbbild zu einer helligkeitsneutralen Umwandlung nach schwarzwei√ü kommt, habe ich in fr√ľheren Beitr√§gen schon beschrieben.

Das sollte uns bewusst sein, wenn wir das n√§chste Mal wieder ein farbiges Bild in schwarzwei√ü umwandeln und in Lightroom oder Photoshop bearbeiten. In Wirklichkeit stellen wir hier den Urzustand unserer Umwelt wieder her, der durch den digitalen Farbsensor k√ľnstlich erzeugt wurde. Vielleicht f√§llt es mit diesem Wissen dem Fotografen auch leichter, sich die Welt da drau√üen nun besser in schwarzwei√ü, oder genauer gesagt mit unterschiedlichen Helligkeiten vorzustellen, was ja eine wichtige Voraussetzung f√ľr gute schwarzwei√ü Fotos ist. F√ľr mich zumindest trifft das zu.

Licht und Kontraste.

Kontraste sind f√ľr unsere F√§higkeit zu sehen und Dinge zu unterscheiden die wichtigste Voraussetzung.

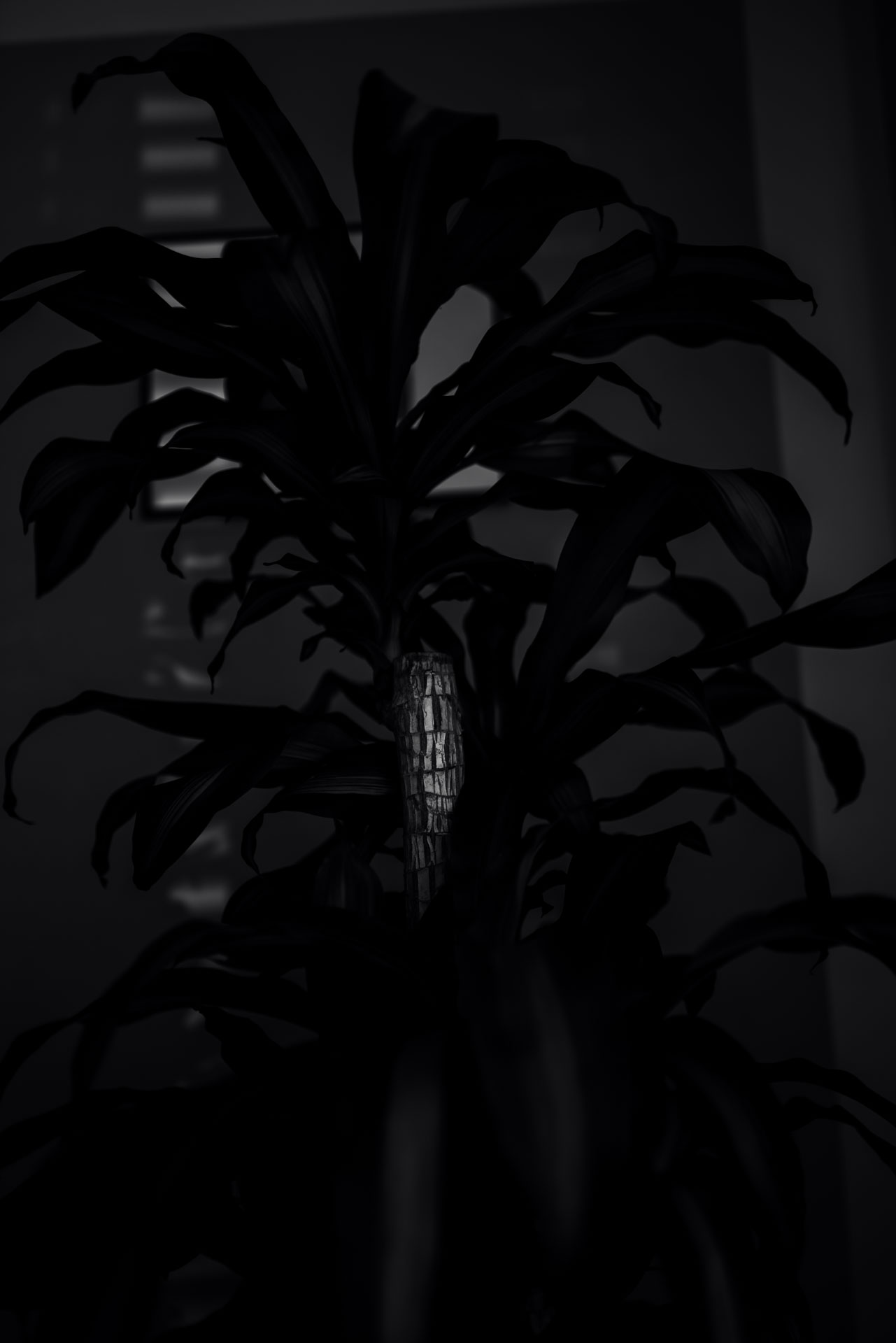

Kehren wir gedanklich zur√ľck in eine n√§chtliche Situation eines v√∂llig abgedunkelten Zimmers. √Ėffnen wir die Augen, sehen wir zun√§chst √ľberhaupt nichts. Aber wenn sich unsere Augen nach einiger Zeit an diese Dunkelheit gew√∂hnt haben und es aus dem Nachbarzimmer einen Hauch von Licht gibt, nehmen wir erste Formen oder Umrisse wahr. Das ist extrem niedriger Kontrast, aber wir k√∂nnen Umrisse differenzieren und uns orientieren.

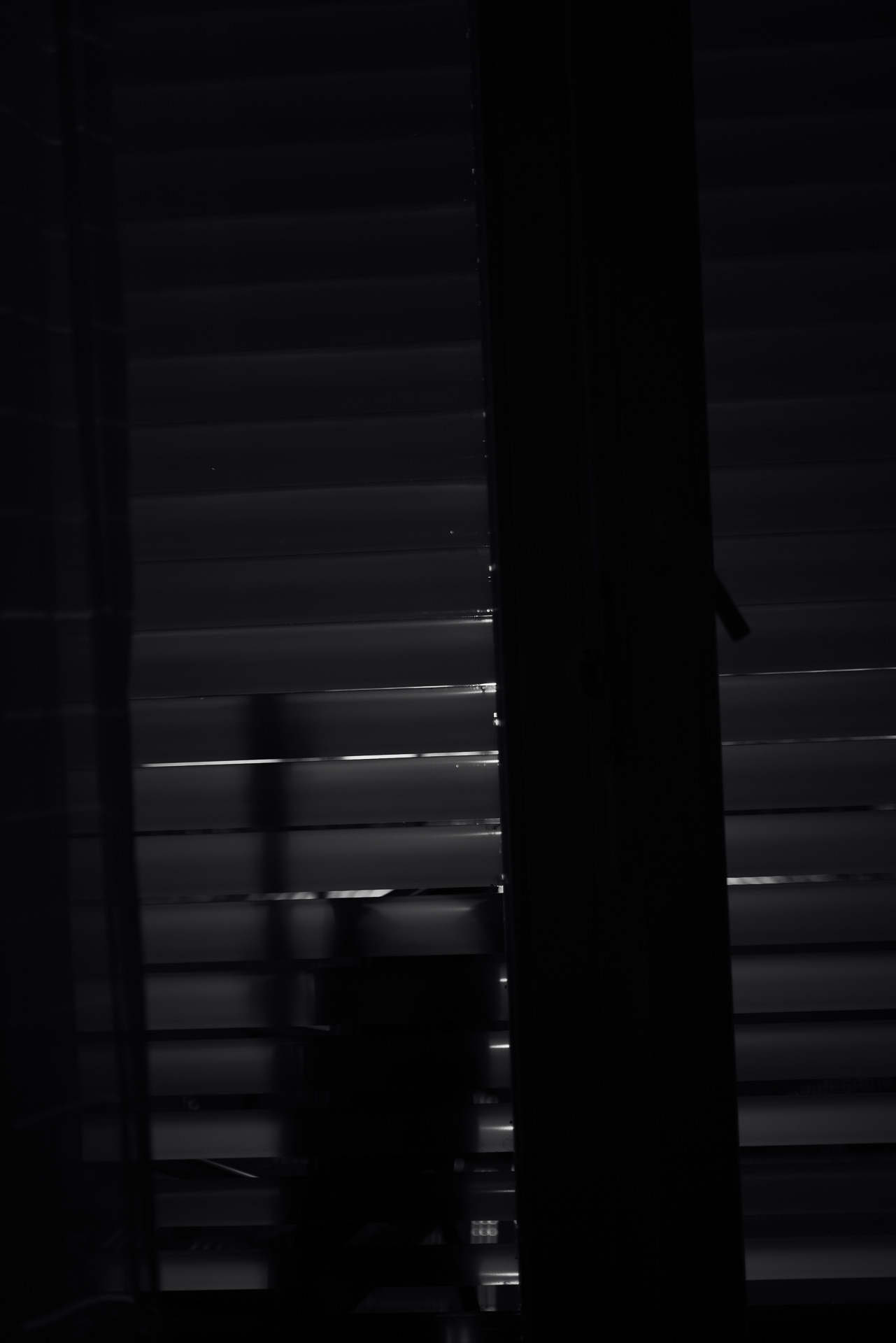

Folgen wir der möglichen Lichtquelle, werden wir an dessen Ursprung den Lichtspalt mit hoher Helligkeit wahrnehmen, auch wenn das Zimmer damit immer noch dunkel bleibt. Allein an der Stelle des Spalts haben wir einen extrem hohen Kontrast, den unser Auge zu bewältigen hat. Der Lichtspalt und seine direkte Umgebung lassen hier vielleicht erste Details erkennen, während der Rest in Dunkelheit verharrt und nur geringe Umrisse wahrgenommen werden können. Farben werden wir in diesem Umfeld nicht wahrnehmen.

Anders ist dann die Situation am n√§chsten Morgen. Das Tageslicht kommt aus allen Fenstern und T√ľren herein und wir nehmen unsere Umwelt im normalen Kontrastumfang wahr und sind auch in der Lage Farbe zu sehen, weil das Licht Gegenst√§nde anstrahlt und Farbe mit entsprechender Wellenl√§nge reflektiert wird.

Noch sp√§ter im strahlenden Mittagslicht werden die Kontraste dann derart hoch, dass wir unsere Augen sch√ľtzen m√ľssen, um sie nicht zu sch√§digen. Alle Details lassen sich nun vollst√§ndig und klar differenzieren.